eee tam, kiedyś granie w tym wieku w D&D było dość popularne. Sam jakoś tak zaczynałem.

Propozycja ode mnie - świeczki (10 świeczek - Ten Candles) zaadoptowane pod coś mniej mrocznego. W świeczkach grałem masę settingów i wszystko działa (obcego, SW, oryginał). Będzie mniej nudny niż przy D&D itp., a potem można myśleć o czymś innym.

Role z filmów Snatch (bardzo pasował i dobrze odegrał) i Ad astra (nie zj*ba* tego, bo scenariusz sam się grał i aktor tu jedynie mógł popsuć - główna postać nieco mono, ale nie to jest clue filmu)

Ustawienie dość proste i jedyne pod "master setting - referencję"

Odpalamy hdr na windows - skrót windows + alt + b (niektóre gry robią to automatycznie, po włączeniu w nich opcji hdr).

Gdy jesteśmy w trybie gry na monitorze - odpalamy ustawienia, zakładka gra >>>> mapowanie tonów HDR:

- HDR10+ gaming podstawowy;

- Gra HDR wyłączone (włączenie zmieni odpowiedź mocy - wszystko w półtonach stanie się jaśniejsze, niż twórca zaplanował - niektórym to się podoba);

2 rzecz to ustawienia >>> obraz >>>> eksperckie:

- gamma powinna sama wskoczyć na BT 2084;

- przestrzeń kolorów dajemy na oryginalną (rec 2020) lub użytkownika i wybieramy rec 2020, dlatego, że windows HDR korzysta z rec 2100, który bazuje na rec 2020;

- szczytowa jasność na wysoko.

Chyba tyle.

Zaznaczę, że to inaczej, niż w SDR, bo tam przestrzeń kolorów dajemy na auto i on wykrywa sRGB. Przy przełączaniu Windowsa w tryb hdr mój G8 sam zmienia sobie przestrzeń kolorów z auto (SDR) na użytkownika - rec 2020 (HDR) - czyli zapamiętuje ustawienia dla danego urządzenia.

Tak społecznie, to rola nadaje sens życiu.

Najczęściej w tej najbliższej grupie społecznej - rodzinie. Bycie ojcem/matką, bratem/siostrą itd.

To tej roli większość podporządkowuje swoje życie.

Gdy jesteśmy po 30, utraciliśmy już dawno rolę syna/córki, brata/siostry, a nie mamy roli ojca/matki, to zaczynają się problemy i szukanie ucieczki lub zastępstwa (bycie "tym" dobrym wujkiem lub jakieś matkowanie kotom/psom).

W sumie podchodzę podobnie, ale mam też drugi wyjątek co do oleju - zakup nowego auta i "dotarcie" silnika.

W nowym zmiana po 2tys. km powinna być obowiązkowa. Dla spokoju po kolejnych 2-3 też bym zmienił i dopiero dalej interwały.

Dość sensowne badania prowadzi właśnie podlinkowane R2D - Laboratorium dla kierowców

Gościu bada oleje przepracowane, ma już sporą bazę do porównań i czasami wychodzi, że to nie liczba kilometrów powinna wskazywać na wymianę oleju. Niby ten sam olej, podobne silniki, ale jeden w gazie i z układem hybrydowym i już kupa. W badaniach wychodzi, że po 5k km olej powinien być już zmieniony. W drugim aucie nadal był "dobry" po 10k km.

https://youtu.be/-hEljdmEu-I?si=wMt28UJzFI-CIX_a

Tak z ciekawości, co ile i jaki olej. I czy robicie płukankę przed wymianą?

Ja co 8000-10000km lub co rok (w zależności co szybciej).

Leje wyłącznie japoński Eneos, gdyż autka z japońskim silnikami.

A tu ciekawostka, jeżeli ktoś używa longlifówi oraz stosuje się do zaleceń producenta/ASO w kwestii interwałów. Zabawne, jak producenci zalecaj niszczyć nam auta.

https://youtu.be/UfpytP48q5Q?si=I6RQPSMAxfFXvZqI

Jeżeli typowo pod gry, to rozsądniej może być wziąć Ryzne 5 7600 i połączyć go z RTX 4070ti, natomiast połączenie, które stworzyłeś nie jest złe - faworyzuje gry oparte na cpu oraz ew. wymiany kart na lepsze w przyszłości.

Z dysków KC3000 lub SN850x.

Z zasilaczy CPX-850FC lepszy (podałeś dwa Chieftec, ale to jeden i ten sam model), gdyż jest na pojedynczej szynie 12V. BeQ ma podwójną, co jest gorszym rozwiązaniem. Chieftec lepszy energetycznie, ale ma dość agresywną krzywą wentylatora (natomiast przy takim zapasie mocy i tak go nie usłyszysz).

Inna sprawa, że do takiego zestawu spokojnie 650W wystarczy i to ze sporym zapasem, ale jak chcesz kiedyś wrzucać jakaś topową kartę graficzną, to można 750W.

Z płyt Asus TUF GAMING B650-PLUS wi-fi w zupełności wystarczy do zasilania każdego procka AMD. Nie wiem, jak pozostałe twoje wymagania - dzwiękówka, porty m.2 itd., ale serio - tę kasę lepiej włożyć w GPU.

Co do zestawu - da się optymalizować. Wybrać tańszy (ale dalej dobry) zasilacz, wybrać tańszą (ale dalej dobrą) płytę i wrzucić kasę w 2tb ssd lub GPU. Da to dużo więcej.

Niech GPU na chwilę będzie poza równaniem.

Jeżeli ma być stałe 60hz, to CPU musi sobie radzić w miejscach procesorowych, niezależnie od GPU (by nie było mikroprzycięć)

Ryzen 5 7600X powinien zapewnić utrzymanie powyżej 60fps, przy minimalnych spadkach.

Resztą powinien zająć się adaptive sync (g-sync, free sync) oraz generator klatek (trochę niezależny od CPU)

Jeżeli dopłacać, to do 7800X3D (R7 7700X względem R5 w grach niewiele da, gdy piszemy o czasach następujących po sobie klatek).

Czy warto? Nie wiem, ja mam R5 5800x3d i nigdzie się z am4 na razie nie wybieram. Jeżeli grasz dużo w gry procesorowe, to może warto (np. The Last of us Part 1 Remake, Hogwart Legacy z odpalonym RT, Dead Space Remake, Spider Man Remaster z RT), inaczej raczej nie (ale to gdybanie, bo gry mają tendencję do coraz mocniejszego nacisku na CPU).

Za dużo, by pisać.

A w co teraz gram, zamiast nadrabiać? Heroes III hota 1.7 (z nową frakcją :)

Czy ja wiem, czy to takie mocarz?

Cała ta specyfikacja (45% mocniejsza, x tyle tflop lepsza, o tyle lepsy RT, ale zależnie od sytuacji), to dokładnie, jakby przesiąść się z RX6700xt na RX 7800xt. Przy czym wiadomo, że PS5 ma moc bardziej 6650xt, wiec pro to jakby 7750xt (nieistniejący).

Ale to nadal gdybanie (chociaż dość prawdopodobny scenariusz).

1,5x fps brzmi spoko, tylko tu nie wymieniamy samego gpu, jak na pc, a musimy kupic PS5 pro, które będzie za 3k+.

Ale bieżnik ok? Czy też już zajechany o kilka mm?

Michelin to raczej bardzo ceniona marka.

No właśnie mocno rozważałem mocno te Vredenstein, bo kumpel mechanik bardzo chwalił (że obok Michelina będą najlepszymi całosezonowymi).

Czas pokaże, czy Continental da radę.

Z Goodyeara jestem tak średnio zadowolony - były ok, ale po tych paru latach czuć różnicę, a ja tylu km nie robię.

Ja właśnie przed wymianą, więc przeskanowałem rynek od a do z.

Miałem Goodyear Vector 4Seasons gen. 1, zmieniam ponownie na całoroczne (w mieście inne za bardzo nie potrzebne). Padło na Continental AllSeasonContact 2.

Z tańszych rozważałem Vredestein Quatrac lub Kleber Quadraxer 3 (podmarka Michelina), dlatego, że tych km w roku niewiele się robi (5000-10000km) i opona będzie prędzej do wymiany po 5-6 latach, niż z powodu liczby przejechanych km.

Jak u was? Całoroczne czy przekładacie koła? I jakie marki?

Będzie bardziej producentów

1. Najlepsze, które tworzyło kiedyś i tworzy dalej dziś.

AAA:

Valve

Nintendo EPD No.3 (Zelda team)

Indie/art:

Ice-Pick Lodge

Larian Studios (nie wiem, czy to nie do wyższej grupy, ale zdecydowanie gdzieś)

Honorlable: Triumph Studios (Age of Wonders, Overlord); PlatinumGames (Nier Automata, Bayo, Astral Chain); Obsidian, Arkane Studios, IO Interactive, Fatshark, 11 bit studios, Flying Wild Hog (pomimo SW3), może jeszcze Respawn Entertainment (bardziej za Titanfalle).

2. Najlepsze kiedyś, ale martwe dziś

Illusion Softworks (dziś trochę osób w Warhorse Studios) - przejęte przez Take2 (2k czech)

New World Computing (Might & Magic) - bankructwo (ale tę historię powinien poznać każdy gracz)

Black Isle Studios (później wielu w Obsidian, Troika, bioware)

Cryo Interactive (Atlantis, Diuna, Kroniki CK) - wchłonięte przez DreamCatcher (restrukturyzacja Cryo) , a ten następnie przez Jowood (ograniczenie do wydawania, zaprzestanie tworzenia gier przez DreamCatcher)

Westwood Studios (Blade Runner, Eye of the Beholder, Dune 2000, Command & Conquer) - 1998 przejęte przez EA i 2003 zamknięte.

LucasArts (ich przygodówki i gry SW) - dziś niby dalej coś wydają, ale już bez produkcji.

Honorlable: Lionhead Studios aka Petera Molyneux mind (Black & White, Fable), Silicon Knights (Eternal Darkness, MGS TS), Factor 5 (Rogue Squadron), Pandemic Studios (Battlefronty, Full Spectrum Warrior, LotR Podbój), The Neverhood, Inc.

3. Najlepsze kiedyś, dziś kicha lub średniawa

Konami

Piranha Bytes

Telltale Games

RTX 3070Ti był mocno skopany energetycznie - to wyżyłowany rdzeń. Do tego 8gb i używka. No nie paliłbym się do tego. Bardziej 3080, bo to była spoko karta, ale tu cena.

Rozdzielczość 1080p?

RTX 4060 to jakieś 1400-1500zł. W tej samej cenie zauważalnie wydajniejszy RTX 3060ti, tylko bez generatora klatek i też 8gb vram.

Przyszłościowo patrząc to RTX 4060ti wersja 16gb za ok. 2000 zł ma chyba więcej sensu.

Patrząc na czystą moc, bez generatora, to uśredniając:

RTX 4060 = 100%;

wtedy

RTX 3060ti = 115%;

RTX 4060ti v16gb = 125-130%.

Przedział zależne od gry.

Z drugiej strony do twoich zastosowań RTX 4060 może być wystarczający.

Spróbuję dorzucić trochę niewymienionych:

- The Walking Dead: A New Frontier (widać, że najważniejsze osoby opuściły pokład - ucierpiały dialogi, historia, pacing);

- Afterparty (po genialnym Oxenfree poprzeczka była wysoko);

- Star Wars: The Force Unleashed (zakuć gracza w okowy press x - akcji kontektsowych, po Jedi Knight?);

- Gothic 3 Zmierzch Bogów

- Arcania: Gothic 4 (...);

- Wiedźmin 3 (miała być totalna bomba, wyszła gra bardzo mieszana, z elementami formalnymi, jak klimat oraz dość słabymi, jak projekt świata; do tego brak ładunku emocjonalnego w historii, gdyż ta pojawia się co kilka godzin i jak gra się sesjami, "na przestrzeni" kilku tygodni, to...);

- Call of Duty 3 i pominięci PC :);

- seria Uncharted (tyle było gadania co to nie za seria - jak usiadłem do niej po raz pierwszy, to jakoś tej magii nie zobaczyłem, a zamiast tego, stareńka, oskryptowaną grę, która totalnie nie przerwała próby czasu);

- The Last of Us Part 1 (historia, jak historia, ale rozgrywka..., ja chyba coś mam nie tak z Naughty Dogs, chociaż w Crasha kiedyś się zagrywałem i Part II jest też sporo lepszy w tym aspekcie).

90% podanych tu dowodów jest prawdziwa

Których? Z powyższego obrazka?

Jak to, że Jezus żył, dowodzi istnienia Boga? Żył gościu, został lub nie ukrzyżowany, a reszta to narracja po latach.

I tak z każdym argumentem tego obrazka.

Dla przykładu - piramidy też istnieją, każdy z Faraonów też żył i był "Bogiem". Czy to czynni ich stwórcami życia?

Żeby zaistniało samo życie też musi być jakaś celowość tego powstania,PRZYCZYNA i problem złożoności organizmów żywych ale nie tylko ich rozum,instykt,emocje,uczucia.A maralność u ludzi też wyewoluowała samoczynie z materii? z samych procesów fizycznych czy biologicznych?

What? Przecież wiązania silne oraz słabe, dekoherencja itd. to prawdopodobnie wierzchołek góry lodowej. Za 10-50 lat pewnie będziemy pisali o "boskich oddziaływaniach", których jeszcze nie będziemy znali, ale wiele będzie wskazywało na ich istnienie, jako podstawy do wiązań dających życie - być może przekazujących informacje, będącą początkiem życia na poziomie kwantowym.

Nudząc się wieczorem :P

Dla was Bóg to jakaś abstrakcja

A jest inaczej?

Które z istot niezdolnych do abstrakcyjnego myślenia mają religie? (bezsensowne pytanie... i tak, krytykuje sam siebie)

Memetyka jest tu kluczowa. Mamy religie przypisane do danych społeczności (bogów Egiptu, Mezopotamii itd.) i można badać, jak memy (nośniki informacji kulturowej) się rozchodziły.

Inna sprawa, że jako nośnik podstawowych norm i wartości, religia jest kluczowa, a jej wyniszczanie i "naturalne" wycieńczanie, związane z globalizacją (przede wszystkim tą cyfrową), może być zgubne z punktu widzenia cywilizacyjnego (ale i tu się wszystko dostosuje, więc bym nie panikował).

Inaczej pisząc:

- usuń dowolnego Boga z naszych umysłów na 100 lat - jeżeli nie odnajdziemy nośników memów (ksiąg itd.), to będzie to koniec takiego Boga;

- usuń dowolnego Boga z naszych umysłów na 100 lat i wszystkie nośniki memów. Zapewniam, że narodzi się nowy Bóg.

To kto kogo tu stworzył?

Może to symulacja.

Dziś łatwiej uwierzyć, że Ty czy ja to chat GPT wersja 45, a nad wszystkim czuwa jakiś zespół komputerów kwantowych (nie tych dzisiejszych, a tych właściwych).

Łatwiej też dojść do wniosku, że kiedyś sami będziemy tworzyli takie symulacje* - ograniczając je pewnymi stałymi (jak maks. prędkość dla cząsteczek energii, zdefiniujemy Fermiony oraz Bozony itd.). Oczywiście będziemy też sprawdzali, w jakim stopniu Chat GPT wersja 30 jest w stanie odnaleźć się w takiej symulacji i odkryć te stałe, opisując je swoimi systemami miar.

Ale bez względu na to, czy to symulacja, czy jakiś dziwny wieloświat strunowy (lub jeszcze inny), religia ma rację bytu i będzie towarzyszyła (mniej lub bardziej) istotom zdolnym do myślenia abstrakcyjnego.

Tu ciekawa jest teoria konsensusu - coś istniej, gdy społecznie zgadzamy się, że to istnieje.

*-stworzymy taką symulację szukając odpowiedzi dla powstania naszej. Będziemy te stałe zmieniali tak długo, aż pojawią się oddziaływania silne i słabe. Później zmieniali, aż pojawią się planety, czarne dziury i kwazary. A gdy nie pojawi się nigdzie życie, to sami jest wprowadzimy do symulacji.

Dalej nie wiem, czemu tak usilnie mnie wpasowujesz w takie buty, ale jak dla mnie, to didaskalia czy kanał zero mają na ten moment większą wartość niż TVN czy TVP (aktualne lub pisowskie - bez znaczenia).

W ostatnich 2 miesiącach o CPK naprawdę głośno, a tu cisza...

Nawet nowy rząd wydaje się zmieniać ton...

https://www.youtube.com/watch?v=Ry2Zl3EXzL0

A jaki masz teraz, w ile fps celujesz (=ile hz ma twój monitor)?

Zrzesza, stopniując:

R5 3600

R5 5600

R7 5800x3d lub R7 5700x3d

Wszystko zależnie od budżetu.

Jak po taniości, to ten TCL, jak drożej to OLED (77 lub 83"), a ja nie, to tylko SONY XR-85X95L.

Disel? 6 biegów? Jak tak, to uważaj, bo w d4d i dcat wtryski padały przy podobnym przebiegu, a wał 2,4,6 lubił się posypać.

To nie żaden syntetyk, a spadki do low 30/40 fps w Hogwart to norma w Hogsmeade czy Wieży obrony przed czarną magią i są odczuwalne podczas rozgrywki.

Nie ma znaczenia, czy z gsync (czas klatki na monitorze 25-30ms, czy bez - 33ms, ale stałe w tych lokacjach). Badania wariancji jasno wskazują, że zmiana odtwarzania klatki powyżej 4ms jest przez część użytkowników odczuwalna (poniżej 15%); 8ms przez lekko ponad połowę, a 16 ms przez 95%. Dlatego bada się wariancję, a brak gsync tylko pogarsza sprawę (wydłużając te czasy dla powielania klatek).

Innymi słowy - kupujesz kartę RTX 4090, bo jest o 50% lepsza od RTX 4080? Czemu nie zostać na RTX 4080, skoro w 40 fps da radę grać z gsync?

Zbadaj to jeszcze raz, używając CapFrameX, wariancji i np. Hogwart Legacy z rt i dlss lub spider mana z włączonym RT i dlss.

Good luck, ale i9 9900k bedzie w plecy w 1440p jakieś 30-40%.

https://youtu.be/6UAES7F48EU?si=zmzfhGlL8TUlMJae

Jeśli poskładałeś wszystko jak trzeba następny crash w grze zobaczysz -> nigdy.

Windowsa to nie jest tak trudno scrashować.

Sam z rok nie widziałem blue screen (pomijam kwestie testów sprzętu i napięć), ale dwa dni temu, jak testowałem HDR na G8 w RE2 remake, gęsto i często przełączałem się pomiędzy hdr a sdr (window+alt+b). I chyba przy 5 czy 6 przełączeniu blue screen :)

Wyniki na CPU będą mniejsze nie większe to że raz miałeś większy o rzut kosmetyczny to przypadek

Nope

Oczywiście, że UV może poprawiać wynik w syntetykach, chociaż czynników jest masa (temp. otoczenia itd.). Natomiast zakładając dla wszystkiego constans i jedynie robiąc UV, to przy tym, jak dzisiejsze cpu działają (że boostuja na podstawie warunków termicznych), ma to znaczenie.

To, że maił o kilka stopni mniej po UV to też przypadek?

I teraz na koniec grasz w 1440p 21:9 czyli 3440:1440 jakieś 5Mpx + 4080 = CPU jest bez znaczenia. Bo za nim osiągniesz limit na CPU dostaniesz BN na GPU (w większości nowych gier).

Tu masz trochę racji, ale ogólnie bzdura (zresztą błędnie od lat powtarzana). Bez znaczenia w tym przypadku może być UV, bo w grach nie dobije do limitu termicznego, więc to co zyskuje w grach, to cisza (niższa temp, przekładająca się na obroty wentyli).

To nie dotyczy bukarego, ale wytłumaczę, żebyś nie powtarzał jak inni.

Problem z tym twierdzeniem jest taki, że nawet w 8k dany cpu może wpływać na klatki. Nawet gdy średnia liczba klatek dla prawie wszystkich cpu jest taka sama (limitowana przez BN od strony GPU), to po zbadaniu sprawy mikroprzycieć, okazuje się, że w grach kładących nacisk na cpu (wymiennie ponownie np. The Last of us Part 1 Remake, Hogwart Legacy z odpalonym RT, Dead Space Remake, Spider Man Remaster), CPU dają różne wyniki wariancji następujących po sobie klatek, czyli, prosto pisząc, mikroprzycieć (a to one są gorsze od stałego niskiego FPS). Mikroprzycięcia badamy najlepiej sprzętowo, chociaż programowe badanie też jest dość dokładne (i służy do tego CapFrameX).

Na obrazku obok mikroprzycięcia zbadane sprzętowo przez igorslab dla topowych CPU w Far Cry 6, 4k, RTX 4090.

Tłumacząc dane. na żółto mamy wariancję powyżej 8ms. Oznacza to, że CPU wpłynęło na generowanie dwóch następujących po sobie klatek (np. klatki nr 7355 i klatki nr 7356 w danym teście) i frametime (czas generowania klatki) różnił się 8ms lub więcej (czyli np. klatka 7355 powstawała 4ms, a klatka 7356 ponad 12ms). Jeżeli przez to został przekroczony czas związany z odświeżaniem monitora (16,7ms dla 60hz; 8,3ms dla 120hz itd.), to mamy mikroprzycięcie.

Dlatego na czerwono jest >16ms, bo wtedy mamy pewność, że doszło do szarpnięcia klatek, nawet na monitorze 60hz.

Może się też wydawać, że 0,5% klatek na mikro przycięci to niewiele, ale jest to zauważalne, bo piszemy o szarpaniu gry, a nie niższym fps.

Jak widać nawet w 4k cpu może mieć znaczenie. Żeby było ciekawiej, w 1080p CPU będą dawały inne wyniki, gdyż w niższych rozdzielczościach (=wyższym klatkażu od strony GPU), będzie wyższa przepustowość danych, pamięć cpu (czy to cache, czy ram) będzie miała większe znaczenie itd.

W grach raczej ciężko o dławienie, chyba, że masz coś źle zamontowane.

Ogólnie Cyber bardziej dociska GPU niż CPU, tym bardziej w 4k.

Ja już w tym wątku kilkukrotnie podkreślałem, że nie jestem zwolennikiem wyżyłowanych cpu od intela, chociaż amd też się tu jakoś nie popisało (AM5 ma za gruby odpromiennik, który hamuje przewodnictwo cieplne; AM4 było genialne pod tym względem). W obu przypadkach najlepiej zrobić UV, żeby było chłodniej i, przede wszystkim, ciszej. Czy w grach to może mieć znaczenie? W tych, które dociskają CPU i gdy cenimy ciszę, to tak. Piszę o np. The Last of us Part 1 Remake, Hogwart Legacy z odpalonym RT, Dead Space Remake, Spider Man Remaster, chociaz takich gier jest coraz więcej.

Także polecam UV - dla ciszy.

Pytanie, czy tam (do obudowy Bukarego) wchodzi na górę aio 280 mm?

Arctic Liquid Freezer II 280 lub Thermaltake Toughliquid 280 ARGB Sync byłby ok wtedy.

Jak nie, to wersje 240 tych chłodzeń.

Co do wentylatorów, tak - to te, Vardary. Są świetne, tylko też warto się pobawić krzywą, bo na maxa są dość głośne.

Bardziej miałem na myśli, że jakbyś jakieś miał, bo dwa nowe, dobre to będzie koszt połowy aio 240mm. Np. Ek wb vardar.

To może być pompka, ale o ile po cyferkach mogłem pisać, że coś jest nie tak, tak tu sam musisz znaleźć źródło.

Pierw upewnij się, że to to, izolując resztę z testów (np. Wyłączając wentyle).

Wątpię, by się zapowietrzyła, ale może (wtedy można odpowietrzyć).

Trzeba też zobaczyć na recki, bo może ten typ tak ma, a dźwięk, który kogoś nie irytuje, ciebie będzie.

temp cpu dobre, score też (uwierz, ramka robi robotę, bo 240 mm aio to też nie liga nowych i7/i9).

Karta brzmi źle - podobnie kiedyś mój Zotack Amp extreeme latał - łożysko jednego z wentyli było walnięte (po paru latach), ale on był głośniejszy pod full load.

Co można z tym zrobić?

Perfekcjonista pewnie oddawałbym kartę na gwarę, ale kto wie, czy to uznają.

Ty możesz zrobić kilka rzeczy (naraz lub osobno):

- UV karty;

- zmiana trybu pracy karty (np. w oprogramowaniu od karty lub przełączajać bios na "S" - silent https://www.techpowerup.com/review/gainward-geforce-rtx-4080-phantom-gs/images/biosswitch.jpg )

- dostosowywanie ustawień gier i blokowanie maks fps. Jak masz odpalonego g-synca, możesz zablokować liczbę klatek np. na 100. Swoją drogą qd oled Dell z "F" w hdr chyba z automatu blokuje się na 100hz, więc w opcjach karty powinieneś dać limit 97 fps.

Tu wklejam jeszcze raz, jakie jest optymalne ustawienie g-sync https://blurbusters.com/gsync/gsync101-input-lag-tests-and-settings/14/

No jakoś tak

https://www.cgdirector.com/wp-content/uploads/media/2022/02/Correct-AIO-Installation.jpg

Źle to ciężko założyć

https://youtu.be/rIEB37QXq1M?si=KVP_3KHLarp0Z5-I

W zasadzie pojedynek pomiędzy qd-oled (Dell AW3423DWF lug Samsung G8) a MLA woled (ASUS PG27AQDM lub lg 27GR95QE-B).

Masz już TV Samsunga na qd-oled - w monitorze G8 będzie bardzo podobnie co do jakości obrazu, w tym HDR. Sam mam G8 od jakiegoś miesiąca. Nadal testuje.

Soft jest ok, w dodatku to jeden z dwóch panelów qd oled, które w hdr nadal oferują 175hz zarówno po hdmi, jak i DP (drugi to MSI, ale tylko po hdmi). Dell AW3423DWF z odpalonym HDR daje tylko 100hz; AW3423DW 144hz.

Port micro HDMI oraz mini DP mi nie przeszkadzają. Kabel obsługujący hdmi 2.1 micro do zwykłego hdmi to 50zł. DP jest w zestawie.

Nie testowałem jeszcze żadnego MLA woleda.

Samsung G8 ma też jeszcze jedną przewagę względem wszystkich pozostałych monitorów OLED - HDR10+. Ty do filmów masz TV i to dużo lepszy wybór, bo chociaż ten monitor ma też system z TV Samsunga, to procesor obrazu jest gorszy i gdy oglądasz coś w HDR z appek na monitorze, to często pojawia się mocna posteryzacja (w SDR jest ok). Także do oglądania filmów czy coś polecam dorzucić tu apple tv box gen 3 2022, natoamsit nadal - ty masz od tego TV.

HDR10+ niedługo już w grach i tam może już ci się przyda.

Co do minusów:

- czcionki są nieco rozmazane w stosunku do ekranów LCD ips, ale nie ma dramatu (gorzej jest na woled), a w Windows 11 możemy to dostosować;

- stutter (chyba największy minus OLED) - pojawia się głównie przy filmach (24fps) i na pc (w trybie gry lub grafiki) nic z tym nie zrobimy. Gdy oglądamy z poziomu systemu monitora (tizen Samsung) lub apple tv, możemy ustawić "wyrazistość obrazu", idąc na kompromis pomiędzy niwelowaniem stuttera a zwiększaniem nadpłynności.

Ogólnie:

- HDR super (ale to wiesz po TV);

- perfekcyjna czerń;

- płynność dobra (do CRT daleko, ale lepiej niż na LCD bez stroba), tylko ten stutter;

- wypaleń raczej się nie obawiam (jest dużo funkcji przeciwdziałających - najważniejsza to szybki refresh, wykonywany po wyłączeniu do stand by, po 4h działania łącznego, więc nie odłączać go od prądu);

BTW - jak walczyć ze stutterem: https://youtu.be/E5qXj-vpX5Q?si=14Bm0M91ax5cM0JW&t=576

Trochę racji masz (w tym sensie, że im jaśniejszy TV, tym lepiej sobie radzi w HDR10), ale nie - HDR10+/DV zawsze bezie miało przewagę nad HDR10 i wynika to z faktu informacji o maks jasność dla każdej sceny.

Dla przykładu oglądam dowolny film na Disney plus w HDR10 na swoim G8.

Najjaśniejsza scena filmu ma 1000 nitów i dajmy na to, że jest to jakiś wybuch. Inna bardzo jasna scena - np. na plaży ze słońcem w tle, ma już tylko 700 nitów dla maksymalnych detali świateł, ale mój G8 nie jest w stanie tego odtworzyć, bo APL (średnia jasność) sceny na plaży wynosi 60%, a dla 60% G8 uzyskuje 285 nitów.

Odpalam ten sam film na Apple TV (apka lub box gen3 2022) w HDR10+. Wybuch ma 1000 nitów, scena na plaży ma 1000 nitów, ale dzięki metadanym 285 nitów pozwala zachować detal oraz zwiększyć jasność punktową maksymalnych detali świateł (gdyż zmienia się APL i nie jest to już 285 nitów).

Gdzie twoim zdaniem S95c/G8 i HDR10 ma tu przewagę względem HDR10+?

To widać. Porównywałem tak kilka filmów. Kolory w HDR10+ maja większy volume względem HDR10, a każda scena jest w HDR (zachowuje szeroki zakres dynamiki), czego w HDR10 nie widać (zazwyczaj ucinane są detale w światłach).

Nie jest normalne, ale takie chwilowe peaki się zdarzają.

Robiłeś może reset biosu zworką?

Sytuacje u ciebie jest naprawdę dziwna. W idle temp ok, pod obciążeniem takie klocki. Jaką masz temp. po takich 2h grania, a następnie 10 min idle na samym pulpcie?

PS

Jeżeli cię Bukary pocieszy, to znalazłem dwa tematy na redicie z 13700k, których właścicieli ciągle mieli po 100 stopni pomimo aio 360mm i u obu ramka była rozwiązaniem.

Przed wydaniem pieniędzy zrób to, co możesz bez kosztów:

- reset bios zworką; https://www.asus.com/support/FAQ/1030210/

- rozbierz chłodzenie i ponowny montaż.

Ramki są bezpieczne.

Tu masz testy na dobrych mobo, które niby się nie gną, ale to jakby nie o mobo chodzi, a samo gniazdo cpu.

https://youtu.be/lm42GqNEWAs?si=K2M8ei20FVnMmyGt&t=536

https://youtu.be/iYU1OskbY-Q?si=TtjyTrhYr5J4YRjV&t=772

Jakby to równanie ma dwie zmienne - drugą jest wyniki w CB (o ile uległ poprawie)

Ale w tym momencie powinna być już zmiana co do temp.

Czyli problem z przekazem termicznym leży gdzieś dalej w obiegu.

Dlaczego tak naciskałem na UV? Mamy tu małą powierzchnię z 250W. Obniżenie do 210W lub mniej (przez UV - u ciebie dalej lekko ponad 220W) spokojnie powinno zmniejsza problem przepełnienia termicznego. Jeżeli dalej występuje, to problem jest wyżej w łańcuch i może to jakaś błahostka. Coś z pastą, montażem, pompką, podłączeniem tego, wentylami (chociaż ciecz nagrzewa się w miarę prawidłowo).

Wbrew pozorom aż tak dużo możliwości nie ma. Trzeba zrobić listę i eliminować:

- zostawiamy CPU i UV na boku;

- to co możesz sprawdzić bez odkręcania chłodzenia już chyba było (pompa działa, wentyle też, wszystko dokręcone, ciecz nabiera temp.);

- zostaje czapka i transfer ciepła do AIO (pasta, naklejka, banan na ihs - czyli ramka montażowa itd.).

Pierw sprawdzamy rzeczy bezkosztowe i te, które robimy małym nakładem pracy.

QrKo ma 1.308, a obniżył tylko -0.085,

To nie jest tylko, -0,085 do -0,1 to zazwyczaj maks, jaki uzyskuje się na tych intelach przy obniżeniu offestem.

I może to dać dużą różnicę.

Tu uzyskano 9 stopni w CB;

https://youtu.be/GKLyZQ1yuV8?si=fz1lmfAHM2OYTesC&t=228

Tu uzyskano 8 stopni w dół:

https://www.youtube.com/watch?v=fTKt9AeAwoA

Tu uzyskano 11 stopni:

https://www.youtube.com/watch?v=_oZ4is-nTi4

Na PC lab ludzie też uzyskiwali spokojnie 10-15 stopni i to masa przypadków.

Jak dasz radę, zrób test CB bez UV, a potem zaraz z UV, bo "2-3 stopnie" to raczej mało możliwe na tym CPU.

Czyli po nitce do kłębka. Na razie zostawmy ramkę - asus tuf nie powinien łatwo ulegać, więc pewnie docisk jest ok.

Skoro temp. cieczy też, to pompka lata;

Wentyle też kręcą.

Bukary sprawdzał czy wszystko poodkręcane i poprawnie zmontowane.

Ja dalej szukałbym winny w tym auto oc, zawyżonym ustawieniu load line lub czymś takim.

Problem może kryć się jeszcze pomiędzy cpu a chłodzeniem - może coś z pastą, ale to mało prawdopodobne.

jak możesz, podaj jaki vcore leci u ciebie przy teście cb r24?

A tak btw - chyba pamięci nie są w optymalnym trybie - 6000mhz cl48? Takie kupiłeś?

Myślałem, że może rzeczywiście problem polega na tym, że chłodzenie założone na LGA 1200 albo coś nie jest dokręcone, ale tu musi być jakiś inny problem. :(

Tylko jaki. Score w CB r24 w miarę poprawny. Jasne, niższa temp w pokoju, zmiana pasty na nieco lepszą zawsze może pomóc, ale czy problem faktycznie istniej.

Kupiłeś lekki grzejnik, i grzeje. Na moje nie ma co panikować. Czynników jest masa. Płyta może podawać trochę zawyżone napięć (może w biosie ustawiłeś jakąś opcję auto oc lub coś takiego), ta sztuka procka już tak może mieć, może być, że zrobił się banan (ramka prostująca zalecana, ale przecież tragedii nie ma).

- Dokupię tę ramkę. Możecie podać konkretny model, który warto zamówić?

Są dwie firmy, obie sprawdzają się tak samo: Thermalright LGA1700-BCF lub Thermal Grizzly LGA1700 Contact Frame. Ale czy warto to montować? Hymmm, bo ja wiem - sprawdź wcześniej czy pasuje do twojego chłodzenia aio.

No już dawno ustaliliśmy, że grzeje się za mocno. Teraz trzeba sprawdzić dlaczego. Odkręć chłodzenie z procka i pokaż fotki spodu bloku i samego procesora.

No właśnie niczego nie ustaliliście - w zmiennych warunkach (gdzie spory wpływ miało gpu), bez znanej wartości oczekiwanej (czyli "grzanie się w grze").

Oto wynik testu i zrzut ekranu z temperaturami na 3 sekundy przed zakończeniem testu.

Wynik nie jest zły, a cpu miał tu osiągnąć 100 stopni - celowo. Średnia dla twojego cpu w R24 multi to 1602 pkt, a większość użytkowników ma go na aio.

Szybko idzie znaleźć wątek na redicie, gdzie gościu z jednym z najlepszych aio 420 mm ma 1630 pkt.

Na twoim aio spodziewałbym się wyniku w okolicach średniej, a twój wynik daleko nie odbiega. Ludzie poprawiają temp., a co za tym idzie wyniki w R23/R24 (stałe warunki działanai cpu, bez wpływu gpu, ze znaną wartością oczekiwaną) na kilka sposobów przy tym cpu:

- UV;

- płytka prostująca gniazdo (intel CPU Contact Frame LGA1700).

Oba działają dobrze i pozwalają na uzyskanie niższych temp i ciszy w grach; czy wyższych wyników w takim R23/R24.

Z doświadczenia polecam UV.

Czyli jednak konieczne jest UV? Już widzę Raidena i "a nie mówiłem". ;)

Ale mam też drugie :P

"było brać AMD"

A tak serio, by jakkolwiek pomóc, to w grach ciężko stwierdzić, czy to się przegrzewa, czy może miałeś operę w tle odpaloną i miała ona jeden ze swoich skoków na cpu (co skutkuje właśnie osiągnieciem maks temp na większości współczesnych procków), bo średnie temp nie są jakieś tragiczne, chociaż nie są też dobre jak na grę jadącą bardziej po GPU.

Moja recepta i już ją przepisywałem: zrobić test CB R23 z monitorowaniem temp. hw info w tle (wszystko inne pozamykane) i porównać wyniki z innymi i7.

Co do 10 Bit i 165mhz, to akurat zastanawiające. MSI na tej matrycy po DP 1.4 ma max 144hz, tak samo Dell bez "F". MSI ma tę przewagę, że ma jeszcze HDMI 2.1 i tam mam 175hz@10bit.

Jedynie Samsung G8 daje 175hz 10 bit zarówno po HDMI 2.1, jak i DP.

tak nie da się ustawić wartości większej niż 500 (HDR jest włączony w Windows, a tryb HDR 1000 w ustawieniach monitora).

Co do Alan, to chyba trochę inaczej jest, niż piszesz.

Mamy tam 2 jasności:

- jasność gry, czyli "biel kartki", co powinno odpowiadać jasności 100% white screen i powinieneś chyba ustawić bardziej 250 nitów, bo tyle te panele osiągają na 100% white, żeby nie mieć ucinanych detali w jasnościach (screen z gry z detalami białego nieba - gdzie przy 500 nitach ma wszystko zlane);

- maksymalna jasność ekranu - dal świateł punktowych (2-10% powierzchni) i tu sama gra wykryła dobrze.

Oczywiście takie ustawienie na początku wyda ci się bardziej wypłowiałe, bo obniżysz odpowiedź EOTF, ale jest to bardziej adekwatne odwzorowanie HDR (czyl izachownia detali od cienie po światła).

Widać to na załączonym obrazku. Nie wiem, czy to ograniczenie związane z moim systemem (złymi ustawieniami) czy tak po prostu jest.

Co do sreenów, właśnie ciężko tak porównać, bo screen ma jednak pełna informacje kolorystyczną, zdjęcie z tel już nie.

nie możesz zrobić screena w HDR i pokazać nam na forum taki screen jest bez kolorów całkowicie wyprany i wyblakły u ciebie jakieś tam kolory widać nadal więc nie wiem czy faktycznie masz włączony HDR czy tylko napis uruchom grę w trybie HDR, SDR masz właśnie na tym monitorze w okolicach 400 nitów.

To akurat, u Bukarego, to są zdjęcia z aparatu. Jeżeli robił na bazowym iso, jakimś współczesnym bezlusterkowcem, to uzyskał 14-15 EV, czyli dostatecznie dużo, do pokazania "HDR", choć nie w pełni. Oczywiście można zrobić zdjęcie bardziej "HDR" - łącząc kilka niedoświetlonych, w punkt i prześwietlonych.

Swoją drogą ciekawe, jak HDR został totalnie zawłaszczony przez marketing. Przecież moje Eizo - nawet ten retro - spokojnie pokazują HDR w zdjęciach na Adobe RGB.

Tak, jest ok, lecz w tej grze masz bottlwnck od strony karty graficznej (sytuacja porządna) i ogranicza to wykorzystanie cpu (czyli też temp.).

Wcześniej wymienialem gry najbardziej jadące na cpu.

Aż jestem ciekaw twojego zdania.

Czy podobnie jak mi:

- czcionki nie będą jakoś specjalnie przeszkadzały (przed mdoem), chociaż zauważalnie gorsze niż na ips;

- stutter będzie mocno przeszkadzał - to co pisałem o płynności w filmach (czyli efekt pojawiający się przy błyskawicznych wyświetlaczach, ale w technologi sample and hold - za opisem rtings: Due to the near-instantaneous response time, there's noticeable stutter as each frame is held on longer with low-frame-rate content. It's especially noticeable in slow panning shots.);

- hdr uznasz za najlepszy jaki widziałeś (chociaż ja mam spore porównanie i najlepiej wyglądało to tu z hdr10+ w filmach, a ty tego nie doświadczysz).

A tak btw, testowałeś już pc? Jakie temp?

Zależy od gry.

W tych bardziej cisnących po gpu, spokojnie da radę.

W tych nowszych, z naciskiem na cpu, fps może być limitowany dalej przez kartę w 4k, ale cpu może dawać przycięcia (zależne od miejsca w grze).

Piszę o The Last of Us, Hogwart Legacy z RT, Spider man z RT.

W kolejnym etapie powinieneś pomyśleć o zmianie cpu na coś gamingowego jak r5 5600x3d lub r7 5800x3d.

Tak, bez problemów. Ja korzystam z g-sync na G8, który też nie ma modułu NV.

Ważne jest poprawne ustawienie (niezależnie od modułu i wlepki NV):

https://blurbusters.com/gsync/gsync101-input-lag-tests-and-settings/14/

Może faktycznie poczekać na na jakieś 21:9 w QD-oled gen 2, gdzie czcionki będą nieco czytelniejsze?

https://www.youtube.com/watch?v=puwJBwR-Guw

Co do samego dbania o Oled, to warto w Windzie:

- schować pasek zadań (automatyczne ukrywanie);

- ustawić wygaszacz ekranu na np. "ukryj swe myśli".

Z takich rad użytkowych G8:

- denerwuje mnie brak automatyzacji przy HDR w Windows. skrót "win+alt+b", ale muszę jeszcze za każdym razem wyłączyć/zmienić profil kolorystyczny, a następnie w ustawieniach monitora przestrzeń kolorów z auto (konieczna do uzyskania sRGB) na rec 2020/native;

Czy lepszy to nie wiem. Warto sprawdzić czy Samsungi maja natywny g- sync. Oglądałem jakiś model Odyssey i nie miał. Samsung maja lepsze wsparcie dla konsol ale chyba to nie jest coś wartego uwagi w twoim przypadku.

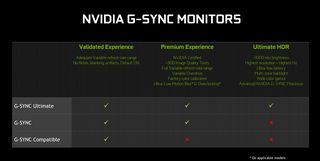

G-sync w 2023 działa trochę inaczej. W zasadzie każdy wyświetlacz VRR jest g-sync compatible (nie potrzebuje do tego chipu Nvidii, bo ma ten od VRR na płycie).

Tu wszystkie stopnie aktualnego g-sync https://www.nvidia.com/en-us/geforce/news/gfecnt/g-sync-ces-2019-announcements/

Obrazek po prawej

Wyższe standardy to tak naprawdę tylko certyfikat Nvidii, że jest HDR1000 i konieczność użycia ich procesora g-sync, który wymaga chłodzenia (przez to Dell AW3423DW hałasuje). Czy jest w jakimś aspekcie lepszy od tych chipów, które dziś montuje się prawie wszędzie do VRR? Kij wie.

HDR to standard taki jak 4k czy 1080p. 99% gier go obsługuje a jak się nawet zdarzy że jakaś nie to

Pytanie jak go obsługują, bo by nie szukać daleko na to Windzie jednak są problemy HDR. Wspominany przeze mnie Spider-man, ogólnie znane problemy z Destiny 2 (swoją drogą na Xbox Series X, po podpięciu do G8, obie gry działają poprawnie z HDR, a na Windows nie). Nie piszę tego, by hejtować technologię, która jest dobra i powinna być standardem. Piszę, bardziej, by uświadomić

za moment dostajesz autoHDR z W11 i sterownika Nvidii.

Auto hdr mod w sumie już jest i jest ok, jak się dostosuje i pobawi nim zależnie od gry - Special K HDR Retrofit

Auto HDR na Xbox działa całkiem, całkiem.

Oczywiście wymóg to min 600 nitów na oledzie i ok. 1000 na LCD. Her Pietrus pewnie widział fakeHDR na jakimś low endzie gdzie nawet go nie było.

Optymalne byłoby 1000 nitów pełnoekranowe. W końcu HDR10 na Windows to Rec. 2100 (koordynaty Rec. 2020), 1000 nitów. To osiągają jedynie monitory profesjonalne (jak Dual layer na matrycach panasa - Sony i Eizo) i może ze 2 mini-ledy. Na swoim G8 w bardzo jasnych scenach wiem, że nie uda się oddać wszystkiego (będzie albo kompresja - czyli wypłowienie; albo hard clip, czyli utrata detali powyżej maksymalnej jasności wyświetlacza w danej scenie - czyli np. oprócz słońca połowa nieba stanie się biała i nie będzie widać chmur, tylko biel).

Mimo wszystko kierowałbym się mniej więcej wytycznymi od Alexa

Kieruj się głownie tym wyborem HDR potem odświeżanie, potem dodatkowe funkcje jak VRR, G-sync, Freesync itd.

W innym wypadku zmiana wyświetlacza, ma mniejszy sens (raz, że użyteczność; dwa, że koszt).

Żeby jak najbardziej zniwelować wpływ aparatu - masz porównanie z EIZO spva.

W tym gorszym scenariuszu

- tekst word, skala 80%, font 11, https://i.ibb.co/Z8YBgtv/DSCF6868-JPEG.jpg

Przybliżenie na piksele

https://i.ibb.co/wyhsLVH/DSCF6868-JPEG-1.jpg

W rzeczywistości pełna czystość tekstu

A dobre HDR na IPS-ach występuje i ma sens?

Tak, choćby ten Asus ProArt PA32UCR-K, którego polecałem (60hz i 4k), ale w 21:9 to ciężko.

Jest wspominany już AOC Agon Pro AG344UXM, ale on ma bardzo wysoką minimalna jasność.

By�� jeszcze ASUS ProArt PA348CGV, ale HDR ma tylko w nazwie... HDR 400, więc tak mocno średnio. Byłby to upgrade względem twojego (120hz, nieco lepsze kolory, obsługa HDR, ale tylko 400, więc bez szans na prawdziwe wow), ale bez szału.

Z bardziej gamingowych będą monitory raczej na VA

21:9

Lenovo Y34wz-30

Philips Evnia 34M2C7600MV/00 (już wspominany - mocne smużenie)

AOC AG353UCG

MSI PAG344CQR

Tylko to VA, więc trzeba posprawdzać dokładnie smużenie.

Potem z campingowych zostają 16:9

ROG Swift PG43UQ (tylko tu kontrast jak na ips, czyli to co masz, ale na tyle duży, że tak ja pisał Alex, zrobisz sobie na nim 21:9 też);

Asus ROG Swift PG32UQXR (tu już lepszy kontrast, ale cena rośnie ostro)

W tym wypadku już bardziej rozważyłbym "wypożyczenie" Samsung G8 lub Della DWF (ew. MSI), by samemu zobaczyć i zdecydować.

W ogóle co się potwierdza? Może i Raiden ma sporą wiedzę ale jak widzę elaborat na temat gorszego niż na IPS/VA postrzegania ruchu bo tam jest ładne rozmycie, a na OLED z super cssem reakcji jest zbyt gwałtowne sample plus hold. i jeszcze to skupienie na strobo (że to niby fajne na tych TN 240 Hz?) to zapala mi się wielka czerwona lampka. Ogromniasta :)

Przecież mam przed sobą te ekrany i CRT, i IPS oraz OLED. Widzę co jak powstaje, w testach ufo można przestawać wszystko i widać, co jest czym. Point sample (czyli stroboskop CRT lub oszukane Point sample ze stroba LCD) zawsze będzie miało przewagę nad sample nad hold w odwzorowaniu ruchu. Nie bez powodu w radarach wojskowych systemów jest to wymóg agencyjny. Ale nie odklejając się. Opisałem to o widzę i napisałem też, że na testowanych OLED Panas i Sony było lepiej.

Ogólnie pomiary rtings, monitors unboxed itd. są bardzo fajnie i pokazują potencjał technologii, lecz wlepianie przy każdym 0,1ms 10 i nadawanie dużej wagi w ocenie końcowej, to trochę marketing.

Tu najbardziej profesjonalne podejście do odwzorowania ruchu https://learn.microsoft.com/en-us/previous-versions/windows/hardware/design/dn642112(v=vs.85)?redirectedfrom=MSDN

Gdyby nie były "gorsze" niż na moim starym IPS, brałbym pewnie OLED

Szybkie porównanie (nie wiem, czy będzie jakkolwiek przydatne, bo wyświetlane na innym monitorze, ale może...), nie patrz na efekt tęczowy/mory na środku - norma przy robieniu zdjęć ekranom oled. Zdjęcia robione z tej samej odległości:

- tekst word skala 120%, font 11, https://i.ibb.co/TTtqhqY/DSCF6864-JPEG.jpg

Bardzo podobnie do tekstu na forum - nie widać tych zielonych (od dołu) lub fioletowych (od góry) przekłamań. Może zielone są delikatnie widoczne.

- tekst word, skala 80%, font 11, https://i.ibb.co/6RqhKSN/DSCF6865-JPEG.jpg

Zielone przekłamanie bardziej widoczne od dołu.

Przybliżenie na piksele https://i.ibb.co/FVr0M2z/DSCF6865-JPEG-1.jpg

Na normalnych czcionkach nie przeszkadza, na małych może.

Możesz to odnieść do tego, co pokazują w reckach.

Z tego, co piszesz, wynika chyba, że nie warto szukać monitora z HDR na tej matrycy, bo ta technologia jakoś pozytywnie na obraz nie wplywa. :(

Co do HDR, to odpaliłem Metro EE i jest bardzo, bardzo dobrze, ale to już testowałem i wiedziałem, że tak będzie. Ogólnie dużo zależy od gier. Ważne też odpowiednie ustawienie monitora. HDR10 na Windows używa Rec 2100 (koordynaty kolorystyczne z Rec 2020), czyli inaczej niż filmy w apkach itd., gdzie większość to DCI P3. Do tego sporo gier ma ten hdr średnio zrobiony (z kolorystycznego oraz gradientowego punktu widzenia). Robią obraz przejaskrawiony i tyle.

Metro Exodus EE ma najlepszy HDR w grach jaki widziałem. RDR 2 robi się lekko pastelowe. Spider Man ma kłopot z maks jasnością, ale da się dostosować, tylko trzeba się pobawić (poświecić czas, potestować, bo wyprowadzenie wyników pomiarów nie daje odpowiedniej jasności). Residen Evil 2 też robi się lekko pastelowy, ale daje radę z jasnościami i zachowaniem detali (ma dobrą kalibrację HDR w grze).

Ogólnie czekam na HDR10+ gaiming, bo to powinno wyeliminować większość bolączek HDR na PC, stąd wybór G8, ale inne pytanie, jest takie, jak to będzie popularny format.

HDR10+ na tv miał ciężkie początki i wszyscy mówili o DolbyVision, ale dziś jest już w miarę dobrze (prime video, rakuten, appleTV, hulu, paramont).

W 21:9 jakieś kompromisy będą. Najlepiej, jakbyś sam zobaczył, czy te fonty w QD OLED ci przeszkadzają. HDR na PC to dalej zamieszanie, chociaż jest lepiej.

Jak budżet poszedł trochę w górę, może trzeba zrezygnować z 21:9 (bo tu raczej twórcy uznali, ze to format adresowany pod rozrywkę - gry, multimedia, HDR) i np. iść w benq PD3220U lub bardziej pod HDR Asus ProArt PA32UCR-K.

Na nich obróbka spoko, wszystko spoko; i na Asusie na HDR da radę, tylko 60hz, 4k.

A nada się też do komfortowej pracy biurowej? Pisałeś o problemie z wyglądem fontów. Będą się prezentować gorzej (mniej wyraźnie) niż na moim dotychczasowym monitorze?

Moim zdaniem tak - ja nie ma z tym dużego problemu teraz odpisuje z niego i jest dobrze. Moim zdaniem na woled jest nieco gorzej, a zwracałem na to uwagę, bo każda recenzja zwraca; i moim zdaniem ten problem jest zbyt uwypuklony. Lekko mniej wyraźnie w porównaniu do ips Eizo jest (nie da się ukryć), ale dramatu nie ma.

Z innej beczki, pograłem trochę w gry, przede wszystkim z HDR i pierwsze wrażenia bez szału. Spider-man albo jest mocno przyciemniony i zachowuje detale w pełnym zakresie, albo jest jasna jak trzeba w HDR (ustawienie bez HDR game w G8), ale gubi detale w highlightach (ustawienie z HDR game w G8) - a ustawiłem mu punkt maksymalnej luminacji oraz białej karty wg pomiarów, więc albo twórcy kręcą dla ogółu (tych co nie mierzą i chcą efektu wow - bez detali, ale jasności), albo coś jest nie tak.

W RE2 remake jest ok, ale ta gra jest taka se pod HDR.

Pobieram Metro Exodus EE - jak do tej pory najlepszy HDR w grach jakie testowałem i tam zobaczę.

Co do płynności w grach, to jest lepiej niż w filmach, gdzie jest to dziwne wrażenie błyskawicznego wznowienie ruchu (rozmycie na LCD wygląda bardziej naturalnie, niż błyskawiczna zmiana na OLED, wynikając z respons time i tego, że to sample and hold). Tu też robotę robi VRR i to, że w grach możemy dodać rozmycie ruchu.

Jak na razie najlepszy HDR jaki widziałem na G8 był a apce amazonu z HDR10+. Gry z HDR10+ dopiero nadchodzą (The First Descendant i inne produkowane na UE 5.2+), ale to też tak, że HDR10+ jest wyłącznie na G8 z monitorów na tej matrycy.

Dam znać, jak w Metro i Chernobylite (btw, w RDR2 było dziwnie z HDR).

Swoją drogą, na Samsungu to z jednej strony dobrze, że można tyle pozmieniać, z drugiej sami co aktualizacje mieszają i zmieniają działanie funkcji.

Teraz siedzę na starym LG 34UC88-B. Widzę, że wciąż jest dostępny w sprzedaży

Monitor masz ok.

Jak chcesz coś pod HDR, to OLED chyba jednak najlepszy.

Jedyna alternatywa, by mieć monitor pod to i to, to płaski AOC Agon Pro AG344UXM - https://tftcentral.co.uk/reviews/aoc-agon-pro-ag344uxm i przy braku multimediów ips nadal ma sens. Tylko ten monitor ma fatalną najniższa jasność - 152 nity. To nawet w dzień, taki jak dziś (pochmurny), zdecydowanie za jasno...

Z taką ostateczną oceną Samsunga G8 jeszcze się wstrzymam, bo trochę muszę go jeszcze potestować, a teraz czasu mniej.

Patrząc na twoje użycie i że ma być 21:9, może by było ok. ale przez duże "M"

- 45%: aplikacje biurowe i do obróbki grafiki czy zdjęć, przeglądanie Internetu;

Kolorki ma ok pod sRGB. Na kalibracji wyszła mi prawie identyczna korekcja co Rtings, więc nawet można te dane wklepać dla 2-punktowego balansu bieli. Problem to ta lekka poświata za literkami (jak pisałem - dla mnie tolerancyjna przy czytaniu/pisaniu), ale to też ma znaczenie przy obróbce photo i tu już może być większa lipa (np. gdybyś korygował poświatę krawędziową na zdjęciu - a ta byłaby tą z monitora).

- 45%: granie.

Właśnie granie muszę jeszcze bardziej przetestować, w szczególności z HDR. Ogólnie, tu by się bardziej nadawał, bo VRR robi swoje. Z 21:9 może nawet najbardziej (i niekoniecznie ten Samsung, ale ta matryca). Problem w tym, że spokojnie większą płynność da się uzyskać - na dowolnym LCD ze strobingiem (ULMB/DyAC+ czy jak tam to dany producent nazywa). Bardziej profesjonalne monitory używające PVM z marszu (strobingu), też, o dziwo, nie będą tak daleko za tym OLEDem. Na zdjęciu po prawej masz porównanie z OLED 240hz (27GR95 - pierwszy od lewej), potem w LCD 360 hz bez włączonego stroba i na koniec z włączonym strobem. Źródło techspot / monitors unboxed YT.

Ale mniejsza, bo większość wystarczy płynność jaką oferuje G8, a za większą zaletę uznają b.dobry HDR.

Sporo też zależy od tego, przed czym teraz siedzisz. Taki OLED pewnie się sprawdzi lepiej, a jak się uprzeć i koniecznie zostać na 21:9, to pytanie o ile jakiś inny LCD byłby lepsze od tego, co masz.

Lista "niby" najlepszy ultrawide: https://www.rtings.com/monitor/reviews/best/by-features/ultrawide

I może ma to sens, bo akurat matryc monitorów 21:9 to nie ma aż tak dużo.

Zostaje kwestia ewentualnych wypaleń, jak masz go mieć na kolejne 6 lat.

Czy z monitorów, które są aktualnie w sprzedaży, testowałeś może coś z dobrym HDR?

Ten G8 jest najlepszym, jaki testowałem z HDR.

Wiem, że nie jest prosto z decyzją, ale też ten monitor (czy sama technologia) nie jest taki jednoznaczny i chyba lepiej być świadomym wad.

Są jeszcze 2 monitorki z mini-led w 21:9. Nie testowałem ich, ale może w tę stronę: Philips Evnia 34M2C7600MV (zakrzywione VA - recka na purepc i toms hardware). Jakaś alternatywa dla OLED (też bardziej w stronę gier i HDR, ale z gorszą czernią, wyższa jasnością - znaczenie tylko przy HDR; i bez ryzyka wypaleń). Tylko będzie ghostling...

Drugi jest płaski i na ips AOC AGON AG344UXM. Zgaduję, że byłby lepszy pod photo, nieco lepsza płynność, ale IPS, nawet na mini led, słabo z czernią w ciemnych pomieszczaniach (większe znaczenie przy multimediach, więc ciebie pomijalne).

EDIT - na Philips Evnia 34M2C7600MV spory ghostling wg https://www.youtube.com/watch?v=k1HqNusTW5A

Co do programików do testów, to już polecałem - darmowy 3d mark ze steam - sprawdzić gpu i cpu score, czy odpowiada wynikom innych RTX 4080 i i7.

Co do monitora, to właśnie testuje Samsunga G8 OLED. Mam tez ostro przetestowanego S90c, Panasa 980 i Sony 80 Tv OLED.

W sumie nie wiem co napisać, by ci nie mieszać. Ja mam zupełnie inne spojrzenie na monitory i odradzam tego OLEDa (21:9 na matrycy samsunga jest 5 monitorów oled). Wrzucę poniżej porównanie z tekstu nt. testów, ale dalej robię pomiary, sprawdzam itd.;

Tekst własny (czemu G8 a nie DELL na testach)

Do wyboru było aż 5 monitorów – każdy na tej samej matrycy. Każdy też oferował podobną jakość z pudełka (fabryczne tryby), lecz nie wszystkie dawał takie same opcje kalibracji. Podobnie wypadały co do ergonomii (tilt, pivot, svilt itd.). Jest jednak kilka sporych zalet Samsunga nad innymi, ale po kolei:

1. MSI MEG 342C QD – oferował najlepsze podłączenia (zwykłe DP 1.4, HDMI 2.1 - 48gb, USB hub, jak i usb-c hub, c alt mode); ładowarkę PD65W, nie dawał natomiast opcji dostosowania gammy (czyli brak pełnej kalibracji, jedynie częściowa przez 1 point balance; zostaje profilowanie); PIP; wyjście audio, brak głośników.

2. Dell Alienware AW3423DW oraz AW3423DWF – oferowały najgorsze podłączenia (DP 1.4 i HDMI 2.0 – a nie ukrywam, że kiedyś może podepnę konsolę), miał najlepsze kolory z pudła, usb hub, brak ładowarki i podobnie jak MSI oferował częściową kalibrację. PIP; wyjście audio, brak głośników. Model z „F” różni się brakiem g-sync oraz 165hz zamiast 175hz, ale karty Nvidii działają z normalnym VRR, więc bez różnicy, tyle, że taniej.

3. Philips Evnia 34M2C8600 – bardzo zbliżona charakterystyka do Della (HDMI 2.0, b. dobry tryb z pudła), lecz praktycznie bez opcji kalibracji (nawet balansu bieli), PIP; wyjście audio, brak głośników.

4. Samsung G8 OLED (min DP 1.4, micro HDMI 2.1 - 40gb, c alt mode), ładowarka PD65W, brak usb huba, pełna opcja kalibracji. Brak PIP, głośniki 5W, brak wyjścia audio.

Powyższe aspekty nieco wpłynęły na wybór, ale nie były kluczowe (chociaż za ogromny minus uznaję brak usb huba, z którego zawsze w monitorach korzystałem oraz brak wyjścia audio pod głośniki). Tymi okazały się dodatkowe funkcje Samsunga. Przede wszystkim multimedialność i system Tizen. Aplikacje jak na TV (Netflix, Prime, HBO itd.) i wszystko spokojnie zadziała w HDR, a nie jak na Windows, gdzie nieraz to przeprawa przez piekło (chociaż dziś jest lepiej niż 2-3 lata temu, to nadal łańcuch uzyskania HDR jest nieco skomplikowany). Do tego HDR10+ (amazon prime, rakuten) oraz HDR10+ gaming (który niedługo debiutuje). Normalnie nie łapie się na takie zabiegi, ale HDR10+ znam i cenię (tak jak i Dolby Vision). Na dodatek pełna kalibracja (nie blokuje opcji w żadnym trybie obrazu) i opcja kalibracji przez apkę ze smartphona Samsung. Dorzucając do tego pełną opcję dostosowania formatu obrazu (czyli filmy 2.35:1 w full screen z aplikacji Netflix, prime itd.). I na ostatek – każdy pozostały QD-OLED 34” jest mniej (DELL z "F", MSI) lub bardziej (Philips oraz DEll bez F) słyszalny (chłodzenie wentylatorem). Ten od Samsunga nie. Możecie się śmiać, ale od lat siedzę przed monitorami chłodzonymi wentylatorami i te potrafią być irytujące, natomiast jestem w tym aspekcie przyzwyczajony do ciszy i nawet mój retro EIZO, po 12000h i 14 latach na karku, jest cichy (niesłyszalny ponad tło, nawet w nocy), gdy mu nie dowalę jakąś dużą jasnością na długo.

Kolejną ważną sprawą były gwarancje oraz wypalenia. Dell i MSI to 36 miesięcy gwarancji; Samsung i Philips 24 miesiące. Nie mam zamiaru go wypalać, ale to OLED. Gwarancje na wypalenia oferuje Dell. Samsung w teorii nie (chociaż to informacje zagranicznych oddziałów, nie wiem jak w PL). Reszta modeli - nie wiem. Ale nie miało to dla mnie większego znaczenia, gdyż przy moim użytkowaniu (80% w 80-120 nitów; 20% hdr) raczej w 2 lata nic się nie pojawi, tym bardziej, biorąc pod uwagę drugi najważniejszy punkt co do wypaleń – technologie przeciwdziałające. Samsung i Philips mają wszystkie opcje. Długi refresh (1h, zalecany po 1500h/2000h); krótki (6/7 min, po każdych 4h użytkowania i przejściu w standy/wymuszony); pixel Shift; jasność elementów statycznych – logo itd. (ABL). Dell oraz MSI mają krótki i długi refresh, brak info o przyciemnianiu elementów statycznych.

Ważna adnotacja – sam tego nie sprawdziłem, gdyż mam GPU Nvidii, ale Oledy na matrycach Samsunga nie chcą za bardzo gadać z GPU AMD. Jedynie MSI i Dell bez „F” nie miały tu problemów. Pozostałem ucinały maksymalną jasność na 500 nitach i/lub miały problem z migotaniem. Do tego, na ten moment HDR10+ gaming działa tylko na gpu Nvidii (tyczy się tylko Samsunga G8, jako jedynego wspierającego tę technologię). Z HDR10+ na ten moment mogą korzystać wszystkie gry na UE 5.2 i nowszym.

Jak widać, na podstawie powyższego, nie ma „idealnego” QD-OLEDa. Samsung byłby dla mnie, gdyby miał usb hub, wyjście audio pod głośniki oraz, może, dłuższą gwarancje z pokryciem wypaleń. Dell i Philips średnie pod ew. konsole, do tego bez smart systemu. MSI wygląda ok. prawie pod każdym względem, poza kalibracją. Ponadto tylko Samsung wspiera HDR10+ (też pod gry) i ma głośnik (nawet znośne), jeżeli to miałoby dla kogoś znaczenie. Poza Dellem z „F” brałem każdy pod uwagę i gdzieś już każdy miałem w koszyku, to jednak Samsung mnie przekonał. Oczywiście Tizen i HDR10+ to sporo marketingowego pierdu pierdu Samsunga, ale też trochę faktycznych zysków. Do tego bezproblemowe podpięcie konsoli z HDR i supersamplingiem z 4k (to oferuje też MSI); oraz pełna kalibracja (to już tylko Samsung).

Po pierwszych testach z marszu mogę powiedzieć, ze chociaż G8 ma własnego smart TV (co jest ogromnym plusem z uwagi na utrudnione życie HDR na windows - np. apki amazon czy Disney nie odpalają na Windows HDR), lecz ogromnym problemem okazuje się procesor obrazu tego monitora. Cokolwiek z niższym bitrate odpalam z apki na monitorze (ograniczone do 1080p i upscaling przez monitor do 1440p), to posteryzacja, pompowanie skalowania i to nie raz i już. Obraz mroczkuje kilka razy na sekundę. Przy wysokim bitrate jest w miarę ok. Rozwiązaniem jest np. podpięcie apple TV (dalej ma hdr10+, 4k - więc będzie supersampling, do tego fps to hz match).

Ale kupujesz monitor, a nie TV, więc pomijając multimedia, to sam monitor ma genialny zakres tonalny, średnią płynność obrazu (na 175hz - tylko w trybie gra jest powiedzmy ok; poza trybem gry 60 lub 120hz i tu jest już gorzej). VRR oczywiście działa (gsync compatible) i nieco pomaga. Miałem już też zonka z przestrzeniami kolorów. W jednej aktualizacji Sasmung niby naprawił tryb auto, w następnej naprawił native ehhhh... w 90% auto będzie odpowiednie, ale np. dla przerabianych hdr, robionych pod rec 2020 (m.in. Piraci z Karaibów na Disney+ w HDR), już trzeba zmienić na native, żeby było ok. Poza tym Kalibracja i profilowanie proste. Co do kalibracja przez smartphona, to jest robiona pod native, więc tak średnio użyteczna. Ale pozostawiając rzeczy, na które może nie zwrócisz uwagi:

- G8 ma przyzwoite głośniki jak na monitor,

- brakuje tego huba usb,

- Czerń, jak czerń, ok, w multimediach się przydaje, ale dalej do grafiki tego monitora się nie użyje.

- G8 jest też zbyt jasny na nocny użytek (min. jasność to niby 60 nitów, ale to przy prawie zerowym kontraście; jak chcemy coś zostawić w rozsądnych wartościach, to bliżej 100 nitów - vide, w zupełnie ciemnym pomieszczenie jako monitor do czytania czy coś, nieużytkowy).

Nie mam też zbyt dużego problemu z czytelnością tekstu (na co zwracają media uwagę przy tych matrycach). Powiedziałbym, że ta poświata przy literakach jest lekko widoczna, ale jest ok.

Podsumowując G8 (i w sumie pozostałem ultra wide na matrycach OLED od Samsunga):

- na TV się nie nadają, chyba, że w parze z apple tv;

- mistyczna płynność OLED jest w przypadku tych matryc średnia (obok CRT czy LCD z włączonym strobingiem to to nie stało) - dopowiem, ze matryce od LG, przede wszystkim te w TV panasa i Sony, gdzie mamy lepsze sterowanie BFI, radzą sobie lepiej; Dlaczego? Sample and hold i tyle w teamcie, a do tego błyskawiczny czas reakcji matrycy przy tej technice szkodzi, a nie pomaga - tworzy screen-door motion resolution effect(na 120hz dość widoczny, na 175hz mniej i widoczne bardziej w filmach niż grach, tym bardziej, że w tych jest opcjonalny VRR).

- genialny zakres tonalny i HDR (potrafią być jasne; przede wszystkim w HDR 10+, chociaż ten jest tylko w G8 - to najjaśniejszy OLED jakiego testowałem);

Co do wypaleń, to każdy z tych monitorów ma technologie przeciwdziałające i jak my ich nie odłączamy od prądu tuż po skończonym użytkowaniu (wtedy przeprowadzają szybki referesh - 6-7 min), to się raczej nie wypalą, tym bardziej jak w SDR będziemy siedzieli na 100 nitach, a nie 240 i wypalali nie tylko ekran, ale też sobie oczy.

Sam pewnie zwrócę/sprzedam G8 i dalej będę siedział na swoim Eizo. Aktualnie trzaskam porównania tej G8 z prawie topowym CRT ;)

Co do wyboru monitora przez Ciebie, to jeżeli nie celujesz w HDR (przynajmniej 20-30% użycia), to OLED ma średni sens. Lepszy będzie jakiś dobry LCD. I to nie kwestia wypaleń , jak pisze Aleks - wygaszacze ekranu nadal istnieją,. G8 po paru min sam włącza swój wygaszacz, do tego kluczowa jest jasność ekranu (240 nit wypali nam wszystko ok, 6 razy szybciej, niż 100 nitów).

Co do monitorów w tym budżecie:

- do SDR i pracy buirowej/lekkiej grafiki i okazjonalnego grania kupiłbym EIZO FlexScan EV2785-BK, a jak się uprzeć na 21:9 to poszukać Fujitsu P34-9;

- do początków z foto itp. kupiłbym EIZO ColorEdge CS2731;

- do CADa oraz wielozadaniowości BenQ PD2725U;

- do hardego grania kupiłbym BenQ Zowie XL2566K;

- pod multimedia i HDR kupiłbym TV.

Xbox wygrywa:

- konstrukcją (lepsze chłodzenie, rozmiary i ogólny pomyślunek),

- game passem;

- boostem gier starszych (do 60/120 fps itd.);

- szybkim powrotem do gry (Quick Resume);

- auto hdr (fajna opcja, dla wykorzystania potencjału TV z HDR; Xbox ma też pełne hdmi 2.1; PS5 ucięte do 40gb, ale bez hdr i 4:4:4 to bez znaczenia)

- dostępnością cenową (xbox series S).

Teoretycznie ma też nieco lepsze GPU i może jest o tych kilka tytułów działających lepiej na Xbox series X więcej niż tych działających lepiej na PS5, ale to niewielki odsetek (ostatnio Alan Wake 2 miał o 60% mniej dropów na Xbox, ale i tak tych dropów nie było tak dużo na PS5).

PlayStation ma przewagę:

- w grach (tylko tu, w tej generacji, póki co szału nie ma),

- kontrolerze (dual sense);

- VR (chociaż to nisza, to Xbox nie ma tego w ofercie).

Kluczowe wydają się gry (chyba, że coś z powyższego szczególnie do ciebie przemawia), więc przejrzeć biblioteki exów i tyle.

Ogólnie Xbox lepsze funkcje, Sony lepsze exy i VR (ale tu też kto, które gry woli).

https://youtu.be/x7fbVYKdCag?si=SrNTcIK432Ipw-VR

Czemu nie robi tego producent od nowości? Bo każda karta jest różna, każda nowa karta chodzi na stabilnych, bezpiecznych zegarach które użytkownik sam sobie może zmieniać.

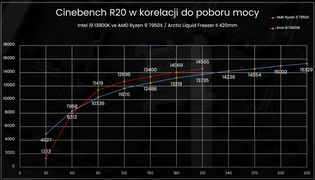

Lepsze pytanie, czemu Intel tak poleciał z limitami mocy (i napięciami)?

I to już każda szanująca redakcja rozgryzła w pierwszym dniu po otrzymaniu cpu - bo na niższych, dotychczasowych limitach przegrywali w syntetykach z AMD. Przy limicie 210W (najmocniejszy aktualnie procek AMD), byli 5% za nimi. Więc dawaj - cyferki muszą się zgadzać i ogień. https://youtu.be/vcjj1sOPeYc?si=USNFdWI_FvqGOH9T&t=732

Obrazek z morele>>>

Tak, niech więc użytkownik się martwi i kupuje lepsze, droższe chłodzenie, kij, że przy 330W, w stosunku do 210W, zyskujemy tylko 10% wydajności (za 50% więcej W), ale jesteśmy lepsi od AMD.

Użytkownik może zrobić:

- UV (obniżyć temp., pobór, nie tracąc na wydajności);

- ustawić sam limit mocy dla CPU (obniżyć temp, pobór, niewiele tracąc na wydajności);

- ustawić limit oraz zrobić UV (bardziej obniżyć temp, pobór, niewiele tracąc na wydajności).

w dobie ogolniedostepnych AIO polecasz mu wieszac kolejne 800 gram na plycie? jess

Daj ty mu juz spokoj z tym UV. Nie jest mu to do niczego potrzebne.

Jakby nie chcę się sprzeczać, bo AIO to dobre rozwiązanie, ale droższe i nie zawsze lepsze.

Ja mam chłodzenie powietrzne, które ma blisko 10 lat. W międzyczasie przetestowałem kilkanaście innych, w tym AIO. Przede mną też jeszcze kilka chłodzeni, które już mam i czekają na swoją kolej do testów.

Z mojego doświadczenia wynika tyle, że powietrze jest jednak trochę mniej problematyczne (nieco łatwiejszy montaż, chociaż to też zależy od modelu). Nie widzę tego, by jakieś aio działało 10 lat, ale Bukary wybrał dobrze i pewnie będzie zadowolony

Druga sprawa to, co piszesz o UV. Jaki jest cel montażu AIO (czyli wydania większych pieniędzy)? Jeżeli uzyskanie niższych temp, to to samo mamy za darmo (pomijając koszt płyty Z, bo ta ma też inne zalety) - robiąc UV. Co się wiąże z niższymi temp, to spadek hałasu, natomiast UV ma tu też bonus - spadek poboru prądu.

AIO w stosunku do nawet najlepszych powietrznych będzie miało przewagę w kwestii temperatur i obiegu powietrza w budzie (temp. gpu), jeżeli zainstalujemy na górze. Ucierpią jednak temp. sekcji zasilania.

I jakby rozumiem, że Bukary nie będzie nic renderował i u niego bardziej to będzie 120-150W w najbardziej wymagających grach na tej i7 niż 254W w Blenderze. Dlatego zawsze pierwsze skrzypce gra użyteczność vs. cena.

PS

Najbardziej wymagające gry dla CPU dziś to The Last of us Part 1 Remake, Hogwart Legacy z odpalonym RT, Dead Space Remake, Spider Man Remaster z odpalonym RT, trochę jeszcze Resident Evil 4. Są też jeszcze tytułu mocno wymagające, ale tam raczej GPU ograniczy FPS, a tym samym użycie CPU (np. Cyberpunk 2.0, A Plague Tale: Requiem). Sprawdź sobie temp. swojego CPU hw info w którejś z powyższych (swoją drogą Avatar też jest dość wymagający).

PPS

I żeby nie było pod i7 i i9, nawet z UV, pod rendering wymagane raczej AIO lub topowe powietrze (wtedy konieczne UV). Do gier powietrze przy i7 jeszcze się obroni.

W zasadzie to trochę przeszła już rada, związana z tym, jak kiedyś działały kontrolery i że dyski SSD były mniejsze.

Chodziło o ograniczoną liczbę zapisów pamięci falsh i to, że kontroler używał w partycji tylko przypisanych komórek. Czyli jak mieliśmy dysk 256, podzielony na partycje 60 gb i reszta, to kontroler mieląc tylko po tych 60 gb (czy też zmniejszając drugą), był w stanie szybciej wykończyć dysk.

To się zmieniło. Dziś mamy lepsze kontrolery, a dyski większe.

Dlatego to taka naleciałość, ale pozostaje pytanie, po co dzielić, skoro dla dysku to już nie ma znaczenia, jak miało dla mechanicznego. I tu wchodzi zarządzanie partycjami vs. zarządzanie folderami.

Zarządzanie partycjami ma tylko minus w przygotowaniu (rozplanowaniu), ale później daje pewne plusy (możliwość deinstalacji systemu itd., bez ruszania drugiej partycji).

Zarządzanie folderami też ma plus w postaci - dla Windowsa czym innym jest przenoszenie/rozpakowywanie pomiędzy folderami a czym innym pomiędzy partycjami. W folderach będzie wystarczająca zmian adresu; w partycjach częściej trzeba kopiować całość (tym bardziej, gdy w operacji będzie uczestniczył folder temp. eksploratora Windows).

Także kto co woli i kto odnajduje w czym większą wartość. Coś za coś, ale jakieś ogromne różnice to nie są, biorąc pod uwagę żywotność i szybkość dzisiejszych dysków SSD.

Jest masa dobrych poradników w necie, więc ogarniesz. Ważne, to złożyć ile się da poza budą, przygotować sobie kablologię i dopiero wkładać jednostkę.

Padło na intela czy amd? Swoją drogą filmik z dziś, na nowych sterach: https://youtu.be/7KZQVfO-1Vg?si=FoIl9PeulgT9stNd

Z rzeczy oczywistych:

- zasilacz wg instrukcji i tego, jak ma być montowany dla trybu półpasywnego lub pasywnego (jeżeli taki ma) - czyli czy wentylatorem do dołu czy do góry (wnętrza obudowy); (przy budach z piwnicą - obudówką na zasilacz, zawsze w stronę wlotu powietrza (wg instrukcji budy);

- ram w dobre sloty (wg schematu z instrukcji płyty głównej - by działały w dualu);

- dyski m.2 też (slot przy CPU ma zawsze linie do cpu, ten dalej ma do chipsetu, ale jak masz takie same dyski to bez znaczenia)

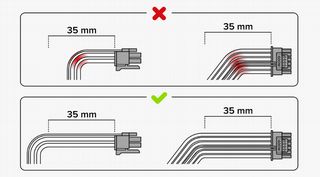

- GPU - u ciebie przy zasilaczu nie ma problemu, ale zawsze też podpinamy wg schemat z instrukcji zasilacza (przede wszystkim GPU łączymy z odpowiednimi liniami pci - ty masz już nową złączkę, więc jest prosto, bo jest jedna wtyczka, ważne, by było klik przy podłączeniu);

- chłodzenie wodne wg instrukcji/pod aio pump;

- trochę zabawy z podpięciem power up, światełek itd. (wg schematu z instrukcji płyty) chyba, że masz już jedno złączkę od obudowy;

- montaż aio do cpu - zawsze pompa musi być pod najwyższym punktem radiatora (pompa poniżej najwyższego punktu obiegu), a wejście wężyków lepiej, by było na dole niż górze (optymalnie też montaż u góry budy - pod sufitem, żeby wentylatory wyciągały powietrze z budy) https://youtu.be/BbGomv195sk?si=VXsuYl7tnIkT2lXF&t=780

- pasta będzie już pewnie na aio, ale jakby miało nie być, to metoda kropkowa (wiele małych kropek lub znak X). Ma to raczej drugorzędne znaczenie; i lepiej dać dużo za dużo niż prawie nic. https://faqs.noctua.at/en/support/solutions/articles/101000353274-how-should-i-apply-the-nt-h1-or-nt-h2-thermal-paste-onto-the-cpu-and-how-can-i-remove-it-

- sprawdzić sobie w instrukcji gdzie jest zworka do restartu biosu.

Po odpaleniu (można już pod odpaleniu windy):

- update biosu przede wszystkim;

- update driverów chipsetu;

- ustawić drugi dysk w menadżerze jako partycje prostego itd. https://youtu.be/zSDCeCsaDco?si=dAFKCRp2YF4f0ma0 ; raczej nie dzielimy jednego SSD na partycje;

- ustawić profil RAM w bios: xmp (dla intela lub expo /docp dla AMD);

- jeżeli wybrałeś intela i płytę "Z", to ja robiłbym z miejsca UV (można z poziomu pulpitu)

https://youtu.be/GKLyZQ1yuV8?si=TN4zz0yB_WkeiDKA

- ustawić

- pobrać hw info

- zrobić testy np. w cinebenchu lub 3d marku (steam), by sprawdzić, czy mamy odpowiedni score dla naszych podzespołów (= czy działają poprawnie)

Co do samej pasty, to Kryonatu jest dobry, ale chyba tylko do testów... Gelid się ostatnio popsuł, więc jak masz dokupować, to arctica mx4/mx6, Noctuę NT-H2, lub EKWB EK-TIM Ectotherm, chociaż jest też jeszcze kilka innych dobrych past.

Ja bym jednak trochę zbadał sprawę.

Pytanie jak płyta (pamiętaj o updacie biosu przed wymianą cpu)?

Do tego jak masz ten ram (dwie kości?)?

znam się/nie znam, też mam swoje "widzi mi się" (np. na cpu preferuję AMD, płyty asusa itd.).

Ja składam swoje kompy pod granie i okazjonalna obróbkę w Davincim Resolve (bo innej już w domu nie robię).

Jakiś specjalnych uwag, niż te wcześniejsze, nie mam. Jeden dysk 2 lub 4 tb.

Zestaw wygląda ok., tylko zasilacz Corsair RM850X SHIFT CP-9020252-EU, zmienił się chyba w wersję bez ATX 3.0 (CP-9020200-EU). Tak chciałeś?

Bo czemu miałbyś mieć problemy. Jeżeli nie kupiłeś w pierwszych 3 miesiącach po premierze lub używałeś tylko do gier (zapis mało ważny); robiłeś aktualizacje na bieżąco i nie używałeś z ZEN 2 na x570, to raczej nie miałeś problemów.

https://www.purepc.pl/samsung-980-pro-otrzymal-nowy-firmware-ktory-chroni-nosnik-przed-nagla-awaria-lepiej-nie-zwlekac-z-aktualizacja

https://eu.community.samsung.com/t5/sprz%C4%99t-komputerowy/problemy-z-dyskami-samsung-ssd-980-pro/td-p/7002085

https://www.benchmark.pl/aktualnosci/samsung-980-pro-jak-rozwiazac-problem-z-zanizonym-zapisem.html

Ja niestety spełniłem wszystkie powyższe. I zęby nie było - dziś mam wersje 1tb (po wymianie proca na 7 5800x3d zapis ruszył) i jest ok. 2tb mam WD sn850x.

Ram to akurat nie ważny (czy raczje drugorzędny) wydawca. Ważniejsze jakie kości. Samsung b-die są najlpesze, ale też swoje kosztują. dalej mamy inne rozwiązania.

Płyta też zalezna od sekcji zasialnia, portów itd. których potrzebujemy, a nie marki. Chociaż Asus ma najlepsze kotrolery pamięci ram.

Dysk: akurat samsung 980pro to największa wpadka samsunga. Już pomijam, że ma niższy zapisy od konkurencji (4500mb w uzyciu vs. 5500-6000 przy kc 3000 lub wd sn 850), bo tego poza testami użytkownik w grach nie zobaczy (tam liczy się odczyt). Już pomijam mały bufor slc, bo to akurat się zobaczy, w szczególności po zapełnieniu dysku, ale po przekroczeniu slc samsung w miarę trzyma prędkość, więc mu wybaczone. Ale to co odwalili z tym dyskiem to komedia. Po wydaniu prędkość zapisu szorowała po dnie, iops też. Dopiero 3 łatka naprawiła temat. Druga sprawa, to że z prockami zen 2 (u mnie był r5 3600) na plytach x570 (gdzie wszystko działa pci 4.0) zapis nie przekraczał 60%nimianlnego (odczyt był dobry). Tu już łatki nic nie dały. A na koniec akcja z wersjami 2tb i tym, że bez aktualizacji 100% dysków padało. Czyli jak miałeś dysk z pidełka i nie zrobiłeś akutalizcjic, to żegnajcie dane. Brawo Samsung. Dla mnie tyle w temacie 980pro, bo wszystko to przerobiłem. I dalej mam wersję 1tb tego dysku.

Przy zasilaczu też trzeba patrzeć na bebechy i producenta oem. Asus, msi, thermaltake czy bequite nie robią zasialczy. Biorą bazy od seasonic, cwt, fortona (fsp) i innych.

Najlepsze bazy na dziś to SeaSonic prime (też w użyciu przez Asusa rog thor). Ale że w testach wypada o 1% lepiej od najlpeszej bazy fsp, to pytanie, czy to jest warte 20%wyższej ceny...

Nie czytałbym też tego, co pisze Leo Tar. Zasilacze mają zapas na skoki i mają zabezpieczenia (chociaż skoki na rtx 30xx wystepowały naprawdę i były spore). Do rtx 4080 polecany jest 750w i to przy i7. Przy r7 7800x3d spokojnie 650 w by starczylo i tak też ja testowalem (na seasonic prime px 650w). Żyje.

Nie kupiłbym natomiast zasilacza z kilkoma liniami 12v zamiast jednej. Takie są często bequiet.

Co racja, to racja, bo w bechmarki się nie gra i też podzielam to zdanie, chociaż może nieco większą wagę przywiązuje do cyferek.

Co do podawania temp. To rzetelniej jest z hw info (sensory), gdzie mamy temp min, max, obecną i średnią od momentu resetu pomiaru. Tam jest też faktyczna temp rdzeni procka, a nie uśredniona (i to od tej faktycznej zależy zbijanie zegarów).

Pisałem, że w grach, bez znaczenia i by się nie przejmował...

Pytanie, czy masz UV u siebie zrobiony?

Nie za bardzo też rozumiem, co pokazuje ten screen. Brak temp max z testu, podanego czasu, max obciążenia z testu, tylko temp po wyłączeniu gry (na to też wskazuje temp schłodzonego gpu)? Czy coś źle odczytuję?

Przy i7 oraz i9 13th/14th gen bez UV - obniżenia napięcia (wymagana płyta Z) i/lub podstawki montażowej (np. Thermal Grizzly Ramka kontaktowa LGA 1700 TG lub Thermalright LGA1700-BCF) są kłopoty z uzyskaniem pełnego scora w cinebenchu, gdyż te procku zbijają taktowania z uwagi na przegrzanie - i tak, nawet na AIO 240mm.

Nie przejmowałbym się, bo w grach nie będzie miało to najmniejszego znaczenia (w sensie liczby FPS - AIO 240mm spokojnie da radę), bo to inny rodzaj obciążenia, z innymi instrukcjami, zostaje tylko kwestia temp/hałasu.

AMD z am5 też święte nie jest, ale akurat procki z pamięcią 3d są fajne zoptymalizowane, więc gorąco raczej nie będzie, nawet na powietrzu (Fortis 5). gorzej z pozostałymi prockami AMD (bez dopisku x3d), ale o nich nie piszemy a i tak nie jest tak źle jak z Intelami. No niestety, czasy AM4, które było bajecznie łatwe do schłodzenia, się skończyły.

Ryzen 7 7800x3d z b650 i tańszym chłodzeniem, wyjdzie podobne kwotowo jak intel i7.

Wydajność w grach na ten moment >>>> źródło pcgh

Wielkich różnic nie ma (intel na trochę lepszych ramach tu, więc Ryzen 7 na takich samych kościach jeszcze trochę zyska), ale są gdy spojrzysz na wydajność per W (następny post)

W przypadku ramu mhz, jak mhz, ale timingi maja takie samo jak nie większe znaczenie.

Co do płyty, to moje wątpliwości nie dotyczą tego, że to słaba płyta. Ona jest dobra, ale na płycie B jeszcze z pół roku temu nie dało się robić UV CPU (nie wiem, jak jest teraz) i to był dramat. Po prostu procki intela i7 i i9 mocno się grzeją, a to przekłada się na hałas (bo niższego scora w cinebenchu poza cinebenchem nie zobaczysz). Rozwiązaniem zawsze było UV. Inni też dokładali ramki prostujące soket, co, w zależności od płyty i chłodzenia dawał od 2 do 15 stopni w dół.

Stąd moja rada - iść w AMD, chociaż am5 daleko do am4 pod względem bezproblemowości.

Ryzen 7 7800x3d + ASUS TUF Gaming B650-Plus WiFi (jak potrzebujesz wifi, a jak nie, to wersja bez) i tyle w temacie. Będzie chłodniej, mniej W i wydajniej w większości gier. Do tego można w przyszłości zmienić CPU, a na podstawce intela nic nowszego nie włożysz.

EDIT, wtedy można na spokojnie wziąć Fortisa 5, a jak chce się AIO, to byle jakie z polecanych wyżej ogarnie.

Na szybki rzut oka:

Grzejnik od intela (i7 14th gen...) na płycie, gdzie pod znakiem zapytania będzie undervolting?

Sama płyta ok, ale to "B". Z CPU i płytą szedłbym w AMD, ale twój wybór.

Pamięci ram można lepsze.

Dysk do zmiany. Mam Samsunga 980 pro, ale mam też lepszego WD SN850x. I kij z testami, bo tych 1000mb szybszego zapisu na WD w życiu nie zauważyłem, ale buffor SLC już zobaczyłem i tu Samsung jest średni (mały buffor, ale utrzymuje ok prędkości). Jak dysk to WD SN850x lub KC 3000.

Zasilacz jak najbardziej ok. Sam mam SeaSonic prime plata, ale dziś bym za to tyle kasy nie dał. Zastanawiałbym się nad Thermaltake Toughpower GF3 850W ATX v3.0. Bardzo podobna platforma do tego RM850X SHIFT. Bazy robione przez CWT - 90% identyko, jednak Corsair ma lepsze filtry i zabezpieczenie "inrush". Thermaltake ma lepszy wentyl (chociaż Corsair też ma b. dobry).

Chłodzenie proca do zmiany. Jako powietrze, to Fortis 5, a z mocniejszych i dwuwieżowych thermalright peerless assassin 120, ale powietrze tak średnio do i7 bez UV. Z AIO Thermaltake Toughliquid 360 ARGB lub arctic liquid freezer ii 360. 280mm też da radę

Biorąc pod uwagę formę Bethesdy (Fallout 4, Faltout 76, Starfield) to Avowed i Obsidian są jedyną szansa na dobrego TES.

O konieczności powstania CPK (lecz w innej, rozbudowanej, formie) mówi też Marcin Piątkowski (profesor ekonomii z US, wykładowca Harvarda i w London Business School, były główny ekonomista PKO BP za PO, dziś główny ekonomista Banku Światowego na Chiny i Wietnam), przeciwnik rządów PiS i tego, co wydarzyło się przez ostatnich 8 lat.

Kolejne świetne didaskalia [poza CPK, o liście otwartym do rządu; o głupocie 13 i 14 emerytur, Balcerowiczu; potrzebie inwestycji i rozwoju; największej potrzebie dofinansowanie systemu nauczania; celu 30-20-10; głupocie PiS w wielu aspektach (TVP, sądownictwo, TK, aborcja - ogólnym ataku na instytucje), lecz braku poważnych błędów gospodarczych co do PKB (choć NBP nie popełniło ich, to stało się organem politycznym); Stanach Zjednoczonych Europy - wzmocnieniu UE; reformie systemu podatkowego oraz błędach polskiego ładu].

Co robić:

- nie obniżać podatków (nie dla 60k wolnych od podatku), gdyż to wpłynie na najbogatszych, a uderzy w możliwości inwestycyjne (zuboża Państwo oraz zwiększa nierówności dochodowe);

- nie dla 13 i 14 emerytur (ale tak dla rewaloryzacji emerytur);

- zastanowić się nad składką ochronną (tymczasowy podatek na obronność i armię);

- podwyżki dla nauczycieli 30% i 20% dla budżetówki (jako kluczowy czynnik w szansie na rozwój i tworzenie podłoża inwestycyjnego dla zachodnich firm);

- CPK jako część rozwoju łańcuchów dostaw i jako podłoże dla zachodnich inwestycji (zachód przestaje inwestować w Chinach - 200-300 mld $ rocznie musi być inwestowane gdzieś indziej i bez CPK ciężko, by w pełni wykorzystać potencjał naszego kraju i chociaż część tego tortu zdobyć). Proponuje związany z tym projekt strefy ekonomicznej pomiędzy Łodzią a Warszawą.

Sporo amerykańskiego myślenia, ale może potrzebujemy. Kolejny punkt widzenia wrzucony do bagna pt. "co dalej z CPK".

https://youtu.be/8fgd6siB7qw?si=iScrJL9g18-iPt6s

No jakby się zgadzam, ale jednak rozumiem, że chcą monetyzować i ciągnąć w stronę Starfield 2, który będzie miał premierę za 15 lat, jak dobrze pójdzie.

Wyłącz Vsynca i jeżeli dalej tak będzie, to albo sterowniki/coś po stronie karty albo za słaby CPU/porblem z CPU.

W sprawnym kompie (od strony software - sterowników itd.), przy odblokowanym limicie fps (czyli też bez Vsync) mniejsze użycie karty niż 95% oznacza bottleneck od strony CPU w danym momencie (vide - CPU nie jest w stanie dokarmić karty, by ta leciała na maksa).

Jest masa gier, gdzie ten R5 7600x nie dokarmi RTX 4070. Nie wiem, jak powinno być z Forza (może jakiś wpływ mają zabezpieczenia MS, bo poprzednie części specjalne wymagające dla CPU nie był). Co do klatek, to obstawiałbym że przy twoich ustawieniach, gdzie z DLSS tak naprawdę mamy poniżej 1080p, to CPU może nie dobijać do granicy vsync (bo karta jest odciążona - dlss, niskie ustawienia itd.), jeżeli masz monitor 100hz+.

Nie wiem na ile (nie)pomogę, ale miałem kumpla (dziś już się nie kumplujemy) z podobnymi problemami. Nie dam rad psychologicznych, bo pod tym względem byłem dla niego bardzo "cruel" i "no mercy".

Warto ogarnąć podstawy: zbadać poziom teścia, sprawdzić czy przysadka dobrze funkcjonuje, zadbać o florę jelitową (ostatnio zawsze na takie stany przepisują jakeś symbiotyki - wg badań ogromne powiązanie).

https://zdrowie.pap.pl/psyche/jelitowa-mikrobiota-nasza-psychika

Dla mnie:

Jak OLED, to tylko Sony lub Panas, bo jako jedyni oferują BFI/stroboskop sterowany (inni nigdy w to nie potrafili) i mają kolory w miarę z pudła. Gorzej u nich z apkami, ale dowolny stick i po problemie. No i Soniacze miały ten problem z short refreshem, ale chyba już ogarnęli (aktualizacja).

Jak LCD to tylko Sony x95L, bo lepszego na dziś nie ma. Samsung jest mega agresywny co do detali w cieniach (zajeżdża je kosztem lepszej czerni - trochę jak na CRT i ustawieniu brightness).

U Samsunga i LG chyba jest ten sam typ matrycy w modelach, ktore wspomnialem.

Nie, Samsung ma swoją matrycę QD-OLED, a LG swoją wOLED. Matryce qd OLED różnią się w TV i monitorach (choćby kształtem subpikseli). W najwyższym modelu LG G3 oraz Panasie 2000 mamy matrycę z optycznym skupieniem - MLA. Pierdu, pierdu, ale faktycznie daje nieco lepszą jasność i ostrość.

Co do rzeczy użytkowych, Samsungi nieco lepiej wypadają w Prime video, bo mają HDR10+. W Netflixie LG, Sony i Panas, bo mają Dolby, chociaż tylko Panas robi je "onboard". Dodatkowo Panas wspiera wszystkie formaty (już pomijam zwyczajny HDR, bo to jest wszędzie): HDR10 + (Prime Video, Rakuten); Dolby Vision (Apple TV, Netflix, HBO max).

Pewnie i tak tego nie zobaczysz, więc bierz to, co ma najlepsze opinie w użytkowaniu (LG lub Samsung :)

Też zacząłbym od ogarnięcia systemu. Masz ssd?

Tak btw,

Kiedy mogłeś kupić x370 i r5 1600 (co do gtx 1060 wystarczyłoby) i dziś przesiąść się na R7 5800x3d i nawet rtx 4080 :)

Terror na podstawie fenomenalnej powieści Dana Simmonsa.

Krótki i na temat.

Jak pod nastoletni vibe, to Invincible oraz Legendy Vox Machiny mogą być.